| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- 정렬

- PIR

- sort

- Queue

- CSAP

- c++

- ML

- sung kim

- BOJ

- Neural Network

- join

- softmax

- TensorFlow

- 시간초과

- 큐

- Linear Regression

- SQL

- 백준

- 모두를 위한 딥러닝

- 한화오션

- Machine learning

- mysql

- 모두를 위한 머신러닝

- deque

- Programmers

- stl

- 알고리즘 고득점 kit

- deep learning

- DFS

- 프로그래머스

- Today

- Total

목록전체 글 (85)

hello, world!

[우리는 여전히 삶을 사랑하는가] 에리히 프롬

[우리는 여전히 삶을 사랑하는가] 에리히 프롬

우리는 여전히 삶을 사랑하는가 -에리히 프롬 - 사랑은 폭력보다 강하다 인간이 삶을 대하는 태도, 삶을 살아가는 방식에 관한 책이다. 사랑에 관하여 배울 수 있었다. 사랑은 인내와 노력을, 무엇보다 용기를 전제로 하는 지극히 객관적인 개념이다. 사람이 삶을 살아가게 하는 원동력이 사랑이라고 생각한다. 폭력이란 단어가 무척 강하게 들리는 반면, 사랑은 유한 말로 생각되는 경향이 있다. 그러나 사랑으로 문제를 해결하겠다고 결심한 사람은 실망을 참고 견딜 용기, 일이 잘못되어도 인내심을 갖고 지켜보겠다는 용기를 지녀야한다. 자신의 강인한 사랑만을 믿으면 되기에 사랑은 폭력보다 강하다. 발췌 우리는 화가 나면 화를 다른 사람에게 투영해 그 사람이 화가 났다고 믿는다. 허영심이 있다면 상대가 허영심이 있다고 느낀..

[ML lab 11-2] MNIST 99% with CNN

[ML lab 11-2] MNIST 99% with CNN

[Simple CNN] import numpy as np import tensorflow as tf import random mnist = tf.keras.datasets.mnist (x_train, y_train), (x_test, y_test) = mnist.load_data() x_test = x_test / 255 x_train = x_train / 255 x_train = x_train.reshape(x_train.shape[0], 28, 28, 1) x_test = x_test.reshape(x_test.shape[0], 28, 28, 1) # one hot encode y data y_train = tf.keras.utils.to_categorical(y_train, 10) y_test = ..

[ML lab 11-1] Tensorflow CNN Basics

[ML lab 11-1] Tensorflow CNN Basics

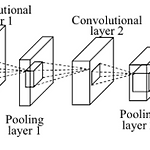

Convolutional Neural Networks 이미지나 텍스트 분류에서 좋은 성능을 발휘한다. 고양이의 뇌가 입력을 한번에 안받고 나누어 받는 것에서 착안했다. image에서 filter의 크기만큼 input x를 받아서 filter W로 하나의 값을 낸다. (Wx + b) ex.) filter 크기인 5*5만큼 읽은 input x가 x1, x2, x3, x4라면, filter w1, w2, w3, w4로 w1x1 + w2x2 + w3x3 + w4x4 + b 연산을 하여 one number를 출력한다. 같은 w값의 filter는 몇 칸씩 이동하며 이미지 전체를 읽는다. stride = 한번에 이동하는 칸 수 output size = (N - F) / (stride) + 1 stride가 커질수록 ..

[ML lab 10] NN, ReLu, Xavier, Dropout, and Adam

[ML lab 10] NN, ReLu, Xavier, Dropout, and Adam

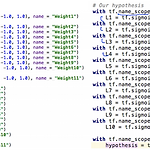

[Vanishing gradient] 위와 같이 9 layer 깊이 학습시켜보았다. poor results가 나왔다. 왜??? Backpropagation algorithm의 chain rule 때문에 그렇다. sigmoid function은 늘 0~1 사이의 값을 출력하기 때문에 layer가 깊어질수록 값이 작아진다. Vanishing gradient 발생! 경사도가 사라지는 현상이다. 첫 부분의 값이 최종 layer에 거의 영향을 미치지 못한다. 이 문제를 해결할 수 있을까? [Geoffrey Hinton] 1. We used wrong type of non-linearity 2. We initialized the weights in a stupid way 1. We used wrong type of..

TesnsorBoard 그래프를 통해 학습이 잘 이루어지고 있는지 한눈에 확인할 수 있다. [5 steps of using TensorBoard] 1. 어떤 tensor를 loging할 것인지 정한다. w2_hist = tf.summary.histogram("weights2", W2) cost_summ = tf.summary.scalar("cost", cost) 2. merge 한다. summary = tf.summary.merge_all() 3. file 위치를 적어 writer를 만들고 graph를 추가한다. # Create summary writer writer = tf.summary.FileWriter('./logs') writer.add_graph(sess.graph) 4. summery를 실행..

[Logistic regression for XOR] XOR 문제를 logistic regression으로 학습시킬 수 있을까? import tensorflow.compat.v1 as tf import numpy as np tf.disable_v2_behavior() x_data = np.array([[0, 0], [0, 1], [1, 0], [1, 1]], dtype = np.float32) y_data = np.array([[0], [1], [1], [0]], dtype = np.float32) X = tf.placeholder(tf.float32) Y = tf.placeholder(tf.float32) W = tf.Variable(tf.random_normal([2, 1]), name = 'weig..

Axis(축) 가장 바깥 []이 0번 axis이고 안쪽으로 들어갈수록 커진다. 가장 안쪽 []은 -1번이라고 하기도 한다. matmul() 등 matrix 연산을 할 때에는 shape을 보고 가능한지 주의해야한다. ex. (2, 2)와 (2,1)의 multiply는 가능하다. broadcasting (warning!) shape이 동일하지 않은 경우에 matrix 연산을 시도하면, 연산을 할 수 있도록 shape을 자동으로 맞추어 준다. reduce_mean() 항상 각 element가 float type이 되도록 주의해야 한다. 축(axis)을 무엇으로 정하는지에 따라 다른 값이 나온다. (축을 명시하지 않으면 모든 element의 평균을 구한다.) tf.reduce_mean([1, 2], axis =..

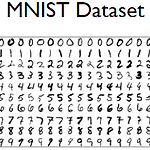

[ML alb 07-2] Meet MNIST Dataset

[ML alb 07-2] Meet MNIST Dataset

import tensorflow as tf learning_rate = 0.001 batch_size = 100 training_epochs = 15 nb_classes = 10 # download mnist dataset mnist = tf.keras.datasets.mnist (x_train, y_train), (x_test, y_test) = mnist.load_data() # normalizing data x_train, x_test = x_train / 255.0, x_test / 255.0 # change data shape print(x_train.shape) # (60000, 28, 28) x_train = x_train.reshape(x_train.shape[0], x_train.shap..